|

ANTES DOS CHIPS

, Um pouco de história .... Uma revolução silenciosa iniciou-se na Universidade da

Pensilvânia. Finalizado em 1946, o Eniac (Electronic Numerical Integrator and Computer) foi o

primeiro computador digital totalmente eletrônico. Pesava trinta toneladas e

tinha 18 mil

válvulas. Funcionários

trabalhavam ininterruptamente trocando válvulas que se queimavam. A

luz e o calor atraíam insetos, que acabavam morrendo em seu interior e

provocando defeitos no funcionamento, originando o termo “bug”

(inseto em inglês).

A

demanda por cálculos balísticos aumentava cada vez mais e alguma providência

deveria ser tomada. Três homens prontificaram-se a resolver

o problema: Herman H. Goldstine, capitão do exército, e John W. Mauchly e J. Presper Eckert Jr., da Escola de Engenharia Elétrica Moore da

Universidade da Pensilvânia.

Eles

propuseram a criação de uma máquina calculadora eletrônica batizada de Eniac. A

máquina utilizava válvulas montadas em blocos de dez unidades, cada bloco com

mais de um metro de comprimento. Havia 200 blocos, o que

dava ao Eniac uma memória capaz de armazenar 20

números de 10 dígitos cada . A esposa do capitão Goldstine, Adele, foi a primeira “programadora” do Eniac. Os programas eram

literalmente diagramas de conexão que ligavam os blocos de válvulas a

barramentos. Para “instalar” um

programa, um complicado diagrama feito à mão guiava Adele, e assim ela ligava

interruptores e cabos de conexão. O Eniac

podia calcular em 20 segundos a trajetória de um míssil que levaria 30

segundos para atingir seu alvo,(o mesmo cálculo

feito numa calculadora manual levaria 2 dias)

Durante a década de 40, outras iniciativas para a

construção de computadores eletrônicos surgiram e tomaram diversos caminhos. Mas foi um matemático,

John von Neumann, no Instituto de Estudos Avançados da Universidade de

Princeton, que deu o grande passo no projeto e construção de computadores. Ele percebeu que

enquanto uma máquina computacional não pudesse modificar seu próprio

processo, ela não teria a habilidade de realizar escolhas lógicas e

consequentemente mudar suas próprias instruções. Para responder

a essa questão, ele projetou o Edvac (Electronic Discrete Variable Automatic Computer)

que formalizou o conceito de programa armazenado. Essa foi a primeira vez em

que alguém propôs um máquina cujas instruções fossem

armazenadas como números numa memória eletrônica. Muitas das idéias e conceitos concebidos por Von Neumann são

empregados até hoje no campo da computação. O FIM DA ERA DAS VÁLVULAS... No

dia 16 de dezembro de 1947, nasceu a revolução digital. Foi em Murray Hill,

estado de New Jersey, EUA, quando dois cientistas do renomado Bell Laboratories construíram um estranho dispositivo com

alguns contatos de ouro, um pequeno pedaço de material semicondutor e um

clipe de metal dobrado. A invenção era capaz de amplificar uma corrente

elétrica ou ainda ligá-la e desligá-la, como um interruptor. Nascia assim o Sem

perceber, nossas vidas foram moldadas por esse estranho dispositivo que a

maioria de nós nem sabe como funciona. O transistor pode controlar a corrente elétrica num material

sólido como o sílicio.Daí

o nome de eletrônica "do estado sólido" para designar

a nova tecnologia que subtituía as válvulas(onde a

corrente elétrica era controlada no vácuo). Foi a partir de 1950 que ocorreu um significativo

progresso nas pesquisas na eletrônica de estado sólido,com a criação de novos processos de projeto

e fabricação de dispositivos semicondutores,que

culminou com a invenção do circuito integrado

por Jack Kilby da Texas Instruments, em 1958.

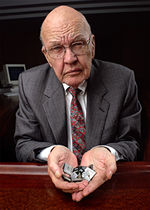

Jack

Kilby Os processos de difusão e

máscara de óxido e o processo planar tornaram-se a base de producão dos CIs.Essas técnicas

permitiram integrar circuitos no mesmo substrato,onde

as conexões elétricas entre os diversos elementos ou circuitos poderiam ser

internas ao chip,conforme reconheceu Robert Noyce da Fairchild,ao anunciar

a sua descoberta.Hoje, milhões de transistores

podem ser construídos minuciosamente em microcóspicas

pastilhas de silício.

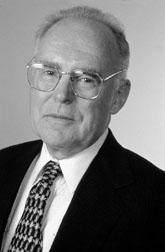

Robert Noyce

Veja: Fabricando um microchip Nos microchips, toda a informação e entretenimento

do mundo podem ser armazenados em formato digital, processados e enviados a

qualquer canto deste mundo globalizado. Mas nem sempre

as coisas foram assim…

A velocidade das transformações Por

milhares de anos, os homens pré-históricos viveram da caça de animais

selvagens e da coleta de plantas e frutas fornecidas pela Natureza. Não eram

tempos fáceis e cada refeição se transformava numa grande empreitada atrás de

alimento. A troca de experiências (isto é, a velocidade de propagação de

conhecimentos) entre os diversos indivíduos ou entre grupos distintos era

incrivelmente lenta. Uma grande transformação veio mudar esse panorama

pré-histórico: a revolução agrícola. As mudanças resultantes desse processo foram profundas, e

dentre elas a domesticação de animais teve um significado essencialmente

importante: o deslocamento humano por longas distâncias foi enormemente

facilitado. A velocidade de propagação de conhecimentos começava a se

acelerar. Muitos

milhares de anos depois, uma nova revolução, iniciada em algumas poderosas

nações da época, assolou o mundo: a revolução industrial. O advento das

máquinas a vapor e um pouco mais tarde dos trens e em seguida dos automóveis

consolidaram o domínio dos homens sobre as máquinas. Um pouco mais tarde,

desvendado o eletromagnetismo, a velocidade de propagação de informações

atingiu níveis impressionantes, graças, sobretudo, ao telégrafo e ao

telefone. Mais

recentemente, o surgimento de computadores pessoais relativamente baratos e

de redes de comunicação globais como a Internet colocam a humanidade frente a

uma nova onda de transformações. As luzes que se acendem são de uma era em

que bits valem mais que átomos e que bens materiais não são mais garantia de

poder e riqueza. Hoje, expressões como “tempo real” e “sob demanda” nos dão idéia de quão rápido corre a informação através dos

canais de comunicação que envolvem o globo. Depois

da revolução agrícola e da revolução industrial, o homem vive a revolução do

conhecimento. Não há atividade humana que resista a esse período de

transição; o impacto das redes de computadores, da microeletrônica, da

nanotecnologia, das telecomunicações é total, pode ser sentido no trabalho,

na educação, no entretenimento, nas artes. O homem, inabalável, segue como

parte integrante e atuante neste cenário de singularidade e de intensas

mudanças tecnológicas. A sociedade é agora “pós-industrial” e vivemos o que é

chamado de “era da informação”. O microchip marcou , assim como a máquina a vapor, a eletricidade e a linha de montagem em outros tempos , um avanço singular no desenvolvimento tecnológico da humanidade. Na nova economia globalizada entram os websites, rápidos como a luz numa fibra óptica, provendo conteúdo especializado e customizável. É a informação em estado

puro, na forma de bits .

Nos

domínios da microeletrônica, nenhuma previsão ficou tão conhecida (e vem

perdurando tanto) como a “Lei de Moore”. Em meados da década de 60, Gordon Moore,

um dos fundadores da Intel, previu que o poder de processamento dos

microchips dobraria a cada 18 meses, enquanto que, ao mesmo tempo, seus

custos cairiam pela metade.

A Lei de Moore Em 1965, Gordon

Moore, um dos fundadores da Fairchild Semiconductor e mais tarde da Intel, publicou em uma

edição da revista Electronics um gráfico semi-log com o número de transistores em um chip de

silício em função da data de seu lançamento no mercado. O resultado foi uma

linha reta, indicando que o número de transistores dobrava a cada ano , o que corresponde a um crescimento exponencial. Nos

anos seguintes, o número passou a dobrar a cada dezoito meses, taxa que, de

certa maneira, é observada até hoje. Uma projeção

feita pela Semiconductor Industry

Association (SIA), baseada na Lei de Moore, indicou

que se alcançará alguns limites físicos por volta de 2005 -- quando o

transistor completará 60 anos. Naquele ano, os transistores terão dimensão da

ordem de 0,1 mícron e chips conterão sozinhos de 5 a 10 bilhões de transistores.

Os chips terão por volta de 10 centímetros quadrados de área e serão

fabricados em wafers de 12 a 16 centímetros de

diâmetro. O duradouro

progresso exponencial da microeletrônica, com chips dobrando de capacidade a

cada 18 meses, é um evento único no desenvolvimento tecnológico da

humanidade. A única outra tecnologia que vem se desenvolvendo com tamanha

velocidade é a comunicação por fibra óptica , a qual

dá-se o nome de fotônica. Essas duas tecnologias é que constituem os

alicerces da “era da informação”.

O sucesso

da “Lei de Moore” deve-se, em parte, às próprias características da microeletrônica , pelo menos em seu estágio atual. A

fabricação de microchips hoje, por mais complexos que venham se tornando, não

foge à receita simples do “wafer” (lâmina em forma

de disco que se assemelha a uma bolacha redonda) de silício coberto de

microcomponentes eletrônicos. Simplesmente ainda não se descobriu melhor

maneira de colocar tamanho número de componentes num espaço tão diminuto.

Mas o futuro do silício pode ter seus dias contados. Outros

materiais com propriedades dos semicondutores, capazes de desempenhar funções

de transistores, já estão sendo pesquisados: são polímeros condutores,

estruturas cristalinas orgânicas, materiais cerâmicos, entre outros. Cada

um desses materiais oferece uma determinada vantagem em relação ao silício

(como maior velocidade, menor consumo de energia, etc.). Essas novas técnicas

abrem novas perspectivas para a microeletrônica e para a computação, e podem

um dia vir a substituir o atual paradigma , baseado

na tecnologia CMOS VLSI , que tornou populares as arquiteturas Pentium, do

PowerPC.

Essas arquiteturas encontram suas raízes nas idéias do matemático John von Neumann, um dos pioneiros

no projeto de computadores durante as décadas de 40 e 50. O próprio

microprocessador é um exemplo do sucesso da arquitetura digital Von Neumman: uma seqüência de

operações acessa instruções e dados de uma memória central, processa-os e em

seguida retorna os resultados.

Outras abordagens para projeto e construção de circuitos

capazes de processar informação já estão em desenvolvimento. Uma dessas

abordagens é a utilização de sistemas analógicos como as redes neurais , inspiradas no modo como alguns sistemas

biológicos processam informação. Para alguns pesquisadores, sistemas

neurais/analógicos representam o futuro da computação. Independentemente

da arquitetura adotada, um passo certo em direção ao futuro é certamente a

flexibilidade dos microchips de amanhã. Chips configuráveis, customizáveis,

capazes de rodar os principais sistemas operacionais serão características

importantes num futuro próximo. Maiores informações,visite: The CHIP Collection

- STATE of THE ART Onde vamos parar ? Mas

existem limites para a computação? Até onde vai o sonho humano de computar? É

certo que, teoricamente, não existem limites. Tudo depende da tecnologia em

que se baseiam os sistemas computacionais. A computação baseada em chips de

silício certamente encontrará seus limites. Nada,

porém, parece ser capaz de frear a vontade do homem de construir máquinas

cada vez mais "poderosas". Embora os custos e dificuldades

tecnológicas tornem proibitivo construir “superchips” para

“supercomputadores”, a supercomputação tornou-se realidade de forma

engenhosa: utilizando dezenas ou até centenas de chips convencionais e

realizando o que ficou conhecido como “processamento paralelo distribuído”. A

computação de alto desempenho e o processamento paralelo é que permitem, por

exemplo, criar efeitos especiais para o cinema cada vez mais realistas . Além

disso, formas revolucionárias de computação vem

sendo pesquisadas, como a computação quântica e a computação biológica com

DNA. Embora experimentais, estas pesquisas vêm mostrando-se bastante

promissoras. Talvez possam substituir os chips de silício na próxima década.

No caso da computação quântica, os cientistas esperam conseguir manipular

átomos, moléculas e suas partículas sub-atômicas

para processar informações. A eletrônica molecular (“moletronics”,

como está ficando conhecida) promete construir superchips do tamanho de grãos

de areia cem bilhões de vezes mais rápidos que um processador Pentium. Com

a miniaturização cada vez mais acelerada dos microchips, será possível

embutir esses dispositivos em todo tipo de objeto ,

e também no corpo humano! Em agosto de 1998, o professor Kevin Warwick, da

Universidade de Reading, na Inglaterra, implantou cirurgicamente um microchip

em seu braço esquerdo. Ondas eletromagnéticas geravam corrente elétrica em

uma pequena bobina acoplada ao microchip. Warwick podia então andar pelo seu

laboratório e interagir com as coisas ao seu redor (portas eram abertas. O

próximo passo de Warwick é implantar um novo chip, mais sofisticado, que seja

capaz de “monitorar” seus impulsos nervosos. O pesquisador quer identificar

os impulsos nervosos correspondentes às diversas sensações e sentimentos

humanos. Em seguida, quer gerar esses impulsos em um computador e

introduzi-los em seu sistema nervoso por meio do microchip.

Em 1957, o

jovem András Gróf deixou

sua cidade natal, Budapeste, capital da Hungria, então sob o domínio

comunista e ocupada por tropas soviéticas. Primeiro foram os horrores da

Segunda Guerra Mundial (1939-1945). Agora era a ameaça de um governo

totalitário. Muitas pessoas desapareciam sem deixar rastro. O jovem sabia que

era hora de fugir: “Eu poderia ficar aqui sentado, e um dia, quando saísse

para comprar pão, nunca mais seria visto”. A Intel percorreu um longo caminho até tornar-se o que é hoje: líder no mercado de microprocessadores para PCs. Os microprocessadores são superchips contendo milhões de transistores que funcionam como cérebro dos computadores. Sem os chips, a chamada Revolução Digital seria impossível.

|